Lorsque l’on évoque le référencement naturel, il existe une manière de découper la discipline en 3 types d’optimisations (autres que seo technique, contenu, popularité !). On peut en effet différencier optimisations on-site, seo on-page et seo off-site.

Le SEO on-site représente toutes les optimisations SEO réalisées sur le site internet, de manière globale. Il comprend du SEO technique, à l’échelle du site, ainsi que du SEO on-page, qui est le SEO spécifique aux pages d’un site internet et ses contenus. Le SEO on-site s’oppose au SEO off-site (optimisations en dehors du site en lui-même).

Définition – Qu’est-ce que le SEO On-site ?

Le SEO On-site regroupe l’ensemble des optimisations SEO qu’il est possible de faire en travaillant uniquement dans le site internet, c’est-à-dire essentiellement sur le contenu, les optimisations et l’arborescence du site web.

Le SEO On-site, à quoi ça sert ?

Plus une page web est optimisée, plus elle a de chance de gagner des positions dans les SERP (Résultats de recherche sur Google), c’est-à-dire d’arriver dans les premières positions des moteurs de recherche. Dans ce cas, concrètement, que faut-il optimiser pour ranker sur Google et atteindre les premières positions avec le travail du référencement naturel On-site ?

Les piliers du SEO On-site

Le contenu SEO

Le contenu que vous publiez sur votre site doit être en relation avec la thématique de celui-ci. Il doit être optimisé en SEO Friendly avec des mots-clés (aussi appelé « Keywords« ).

Pour cela, une analyse sémantique est obligatoire car il existe énormément de mots-clés possible en fonction de ce que les utilisateurs tapes dans les moteurs de cherche, notamment le moteur de recherche de Google qui regroupe 92% du trafic de tous les moteurs de recherche.

Comment trouver les mots-clés pour son site web ?

L’analyse sémantique permet de connaître les mots-clés (comme dit précédemment), les PAA (People Also Ask) et le champ sémantique à utiliser. L’analyse sémantique est obligatoire pour savoir quels mots-clés utiliser, sinon vous ne contrôlerez pas votre SEO.

Le but étant toujours de rédiger pour vos lecteurs et non pour Google ! Mettre des mots-clés oui mais attention à la suroptimisation SEO qui jouera en votre défaveur. Le bourrage de mot-clé n’est pas la bonne solution pour une meilleure visibilité.

Pour trouver des mots-clés, vous pouvez utiliser de nombreux outils SEO comme SEMRush, Ahref, Yooda Inisght, 1.fr, etc…

Nous vous recommandons de prendre un rédacteur web SEO pour la création de votre ligne éditoriale, pour rédiger vos contenus et optimiser en SEO.

Quel type de contenu rédiger ?

Pour optimiser votre SEO On-site, il est recommandé de varier vos contenus.

En effet, que vous écriviez un article de blog, une fiche produit, une fiche catégorie ou bien même votre page d’accueil, les contenus doivent varier pour donner du dynamisme à votre page.

Comment optimiser le contenu de sa page en SEO ?

Voici une liste de contenu non exhaustive pour vous permettre cette variation :

- Texte (Paragraphe, Liste à puce, Bloc de texte, etc),

- Images (GIF, infographie, carrousel, diaporama, etc),

- Vidéos,

- Audio (Podcast, Vocal, etc),

- Contenu embarqué (Vidéos, Carte avec localisation, Jeux intéractif, etc),

- Livre blanc à télécharger.

Plus vous utiliserez des contenus différents plus la lecture sera ludique et appréciée par vos lecteurs.

Chaque contenu doit contenir des mots-clés pour vous positionner sur les moteurs de recherche. Ces mots-clés sont à placer dans des endroits stratégiques de votre site en fonction de la requête que vous souhaitez mettre en avant : Balise alt, Balises titres (Hn), les Métas (Description et Title), le Texte, etc… On vous en dit plus dans notre article dédié au SEO On-Page !

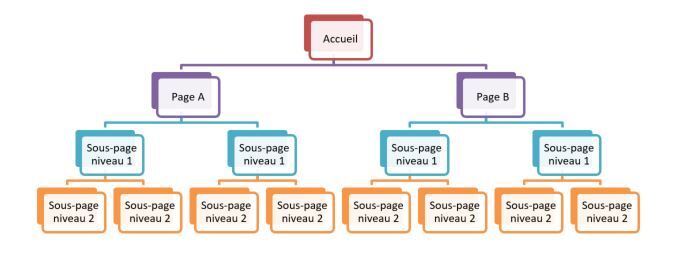

L’arborescence SEO

La structure de votre site joue un rôle déterminant dans votre référencement naturel. Il est donc capital de composer un menu en phase avec l’identité de votre site et ce que celui-ci a à proposer, mais également en phase avec l’utilisateur et ses recherches.

Ainsi, les pages de premier niveau (notamment les onglets principaux de votre menu, qui ont un poids important) de votre site doivent prendre en compte le volume de recherche des sujets que vous souhaitez mettre en avant.

Bref, pour penser une arborescence SEO-friendly, il est capital d’effectuer une recherche de mots-clés !

L’arborescence de votre site est aussi appelée « Maillage Interne« . C’est un fil directeur pour les utilisateurs de votre site web.

En simple, c’est quoi l’arborescence SEO de mon site ?

C’est les liens internes de votre site qui définissent sa structure. Un lien permet au lecteur d’aller d’une page à une autre en cliquant sur celui-ci. Cela dirige l’internaute d’une url à une autre sur le même site web.

Et comme un exemple est plus efficace que 1000 mots : La page, que vous souhaitez mettre en avant, est appelée « Page Mère« , celle-ci fait des liens vers ces pages filles et vice versa. Vous pouvez ainsi construire l’arborescence de votre site.

Exemple de l’arborescence en image :

Cette structure peut être mise en place avec un logiciel de mind mapping, un document Excel ou divers outils.

Le SEO On-site est donc principalement composé de ces fondamentaux. Que vous ayez un site E-commerce, un site vitrine, un site d’entreprise ou encore un Blog, si vous maitrisez ces 3 piliers, vous augmenterez votre visibilité en ligne et passerez devant vos concurrents.

Votre agence Staenk au service de votre référencement naturel On-site

Chez Staenk, nous accompagnons nos clients de leur stratégie digitale et marketing à l’élaboration de leur stratégie SEO, la mise en ligne de leur contenu en passant par les optimisations et techniques pour arriver premier sur Google.

Nous attachons une grande importance à l’accompagnement, l’éducation digitale et la formation de nos clients afin qu’ils soient capable de comprendre nos métiers pour avancer ensemble et dans la même direction.

Vous avez besoin d’aide pour votre référencement naturel, n’hésitez pas à consulter notre Blog sur le SEO ou à nous contacter pour toute question ou demande de devis.